반응형

Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- Phase recognition

- parrec

- paper review

- 유전역학

- nibabel

- monai

- nlp

- TeCNO

- parametric model

- TabNet

- MRI

- 확산텐서영상

- 확산강조영상

- MICCAI

- tabular

- nfiti

- genetic epidemiology

- 비모수적 모델

- 데코레이터

- Surgical video analysis

- 코드오류

- 모수적 모델

- parer review

- precision #정밀도 #민감도 #sensitivity #특이도 #specifisity #F1 score #dice score #confusion matrix #recall #PR-AUC #ROC-AUC #PR curve #ROC curve #NPV #PPV

- PYTHON

- 파이썬

- deep learning #segmentation #sementic #pytorch #UNETR #transformer #UNET #3D #3D medical image

- words encoding

- decorater

- non-parametric model

Archives

- Today

- Total

목록TRANSFORMER (1)

KimbgAI

[NLP] BERT에 대한 간단 설명 (paper review)

[NLP] BERT에 대한 간단 설명 (paper review)

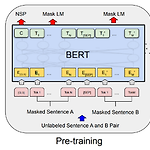

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding Devlin, Jacob, et al. "Bert: Pre-training of deep bidirectional transformers for language understanding." arXiv preprint arXiv:1810.04805 (2018). 2018년에 구글에서 발표된 너무나도 유명하고 NLP 공부할때 milestone이 되는 모델이다. 시작해보자. 개요 언어모델을 개발할때 양질의 pre-trained word representation을 사용하는 것은 매우 중요함. 왜? 좋은 word representation은 down-stream tas..

카테고리 없음

2024. 4. 8. 14:13